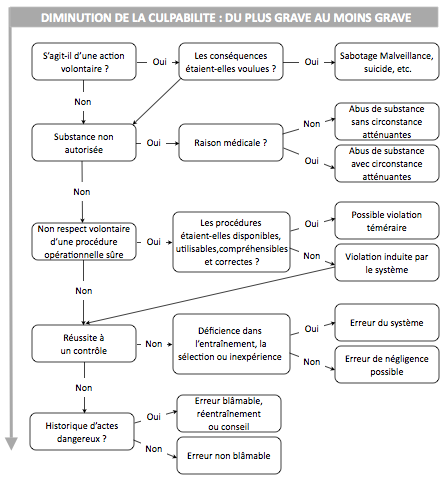

Découvrez les évènements qui suivent en considérant qu’ils sont hiérarchisés en fonction du degré de culpabilité du pilote, en commençant par le plus important.

- Le pilote tente une manœuvre impossible et connue de tous pour être dangereuse ; des passagers sont à bord.

- Après une sortie de piste qui se termine dans un fossé l’enquête révèle que le pilote était sous l’emprise de l’alcool.

- Bien que la zone soit active et donc interdite de pénétration, entre l’évitement d’un nuage et leur connaissance du trafic à l’intérieur de cette zone, l’équipage décide de l’écorner.

- Sujet au rhume des foins le pilote, e toute connaissance de cause, prend un médicament qui entraine des troubles de la vigilance ; il entre en collision avec un autre avion lors de son arrivée au parking.

- Le contrôleur de la circulation aérienne donne un cap à l’équipage qui les entraine directement dans une zone interdite.

- Le pilote s’égare et finit son vol dans un champ alors que les conditions météo étaient bonnes.

- Deux commandes identiques mais de couleurs différentes ont été inversé pendant une visite en mécanique ; le pilote qui repère la commande grâce à sa couleur et non sa position sur le tableau de bord, utilise l’étouffoir du moteur à la place du réchauffage du carburateur et finit dans un champ.

L’autre modèle de REASON

Vous connaissez sans doute déjà le modèle relatif aux accidents appelé « modèle de Reason » ou « Swiss cheese model ».

Dans ce modèle des plaques de protection assurent la sécurité d’un système. Mais il existe des failles dans toutes les protections qui sont représentées ici par des trous dans les plaques. L’accident se produit quand une combinaison d’événements va aligner fortuitement les trous pour passer au travers de toutes les plaques ; toutes les défenses tombent.

Dans ce modèle des plaques de protection assurent la sécurité d’un système. Mais il existe des failles dans toutes les protections qui sont représentées ici par des trous dans les plaques. L’accident se produit quand une combinaison d’événements va aligner fortuitement les trous pour passer au travers de toutes les plaques ; toutes les défenses tombent.

Si ce n’est pas l’unique modèle pour expliquer les accidents, il reste très important pour faire comprendre le rôle des organisations dans les accidents et l’implication de tous les acteurs nécessaire à la sécurité. Son auteur, James Reason, a aussi beaucoup écrit sur l’erreur ainsi que sur la façon dont les organisations doivent travailler pour améliorer la sécurité des activités à risques. Il est à l’origine du concept de la « Culture Juste » dont le but est aussi d’améliorer la sécurité. Ce concept de culture juste a pour but de permettre que les évènements de sécurité soient rapportés par les acteurs responsables au lieu d’être caché. En effet il n’y a pas de progrès possible en matière de sécurité si les évènements s’y rapportant ne sont pas connus, si les mauvaises pratiques ne sont pas découvertes, bref si les acteurs ne font pas de rapports sur la sécurité. Pour cela il faut que ceux-ci soient certains qu’une simple erreur ne sera pas punie et que leur bonne foi ne sera pas mise en cause.

Il ne faut pas oublier que la complexité de l’activité entraine de nombreuses erreurs, en moyenne trois par vol dans le transport public, et que l’erreur est considérée comme une contrepartie incontournable de l’activité. Interdisez de vol un pilote qui commet une erreur, il n’y aura plus un seul avion en vol !

De leur côté les organisations doivent se protéger des comportements qui diminuent la sécurité. Il faut donc trouver un compromis qui profite à la sécurité en garantissant l’impunité quand cela est justifié mais aussi en sanctionnant éventuellement les comportements inacceptables : c’est la culture juste. La définition exacte de la culture juste est : « Une atmosphère de confiance dans laquelle les gens sont encouragés (voire récompensés) à transmettre les informations utiles à la sécurité, mais dans laquelle ils savent clairement où se trouve tracée la ligne qui sépare les comportements qui sont acceptables de ceux qui sont inacceptables ». James Reason nous propose pour cela un arbre de la culpabilité, véritable deuxième modèle de Reason, qui doit permettre de déterminer quand des sanctions doivent être prises mais aussi quelles mesures correctrices appliquer dans les cas intermédiaires qui se trouvent quelque part entre la culpabilité certaine et l’erreur innocente. Cet arbre de la culpabilité constitue la base sur laquelle se fonde tout le concept de la culture juste, qui est elle-même une part importante de ce que devrait être la culture de la sécurité dans une organisation.

Bons vols

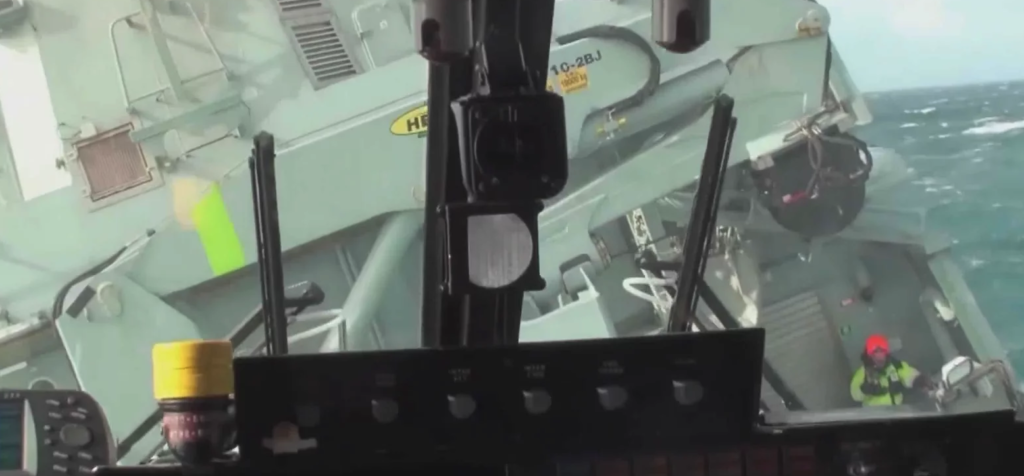

Les photos sont de Daniel.

Reason a certes jeté les bases, mais son modèle est cruellement asymétrique.

Toute erreur est le signal d’une inadéquation, entre un système et l’acteur.

Se focaliser sur la performance de l’acteur, c’est oublier que son activité est directement liée au contexte que lui procure le système.

Autrement dit, toute erreur doit être évoquée selon les deux angles de vue, et le rôle du système doit systématiquement faire l’objet d’une analyse.

A ce titre, le modèle de Reason, de par son asymétrie, a fini par hériter du surnom peu agréable de “7 façons de se faire virer”.

Les travaux d’Hudson, et son modèle de culture “just and fair”, vont plus loin, en considérant par exemple systématiquement la répétition collective, afin de séparer ce qui est systémique de ce qui est individuel. Il envisage systématiquement non seulement l’erreur de l’acteur, mais aussi celle de son supérieur.

Il y a peut être un problème avec le titre de l’article et la conclusion sur la sanction, bien que les nombreux articles sur l’erreur dans ce blog sont là pour démontrer qu’elle est incontournable et qu’elle ne doit pas être confondue avec la faute qui relève soit d’une négligence importante, soit d’une violation des règles “pour convenance personnelle”; les deux à la fois existent, il semblerait (conditionnel) qu’un commandant de bateau soit concerné par ces deux aspects ! En calculant grossièrement le nombre d’erreurs (au sens de LOSA) effectués en moyenne par un pilote au cours de sa carrière, c’est environ 10000 (LOSA US) ! Sans parler d’échec du système, c’est le constat que la survenue de ces erreurs c’est essentiellement le problème du système et non pas des pilotes.

Il existe encore un autre modèle assez parlant, le HFACS (Human Factors Analysis and Classification System) qui a été dérivé du modèle de Reason (encore !) et qui est très intéressant dans la mesure où il s’intéressent aux conditions latentes des accidents, des erreurs…

Note : en déroulant la pelote des accidents avec ce modèle on s’aperçoit assez rapidement que le niveau de sécurité aéronautique français qui est loin d’être au top trouve ses racines, non pas au niveau d’une compagnie, non pas au niveau du milieu aéronautique, mais au niveau national (culture : qui se duplique dans le milieu et les organisations). Nous sommes bien dans la systémique.

Mais si nous revenons au pilote, beaucoup d’experts, à commencer par Reason, disent qu’il y aurait plus de gisement d’amélioration de la sécurité à s’intéresser à ce qui constitue la performance du pilote plutôt que de se focaliser sur ses erreurs (même si elles doivent toujours être analysées).

On peut discuter du pour et du contre. On n’ira pas jusqu’a dire que Reason ment…

OK je sors

Mon témoignage se passe au milieu des années 70′, j’étais pilote-remorqeur dans un aéro-club du Sud Ouest ; après avoir largé le cable, j’effectue ma ressource en virage, prépare la machine et là … oops … baisse de puissance ; je commence par rendre la main et chercher un champs dans l’axe de l’avion puis j’effectue un rapide scan du cockpit et découvre une manette jaune qui ne devrait par être tirée ( mon analyse ne va pas plus loin à ce stade ) … je la repousse “promptement”, le moteur repart, je vire en vent arrière et me pose sans que personne n’ai eu le temps de se rendre compte de l’incident.

Depuis, j’ai effectué une longue carrière aéronautique et j’ai souvent cité cette anecdote pour plaider la standardisation des formes, couleurs et positions des diverses commandes, quelle que soit la taille de l’avion.

J’ai consacré 15 ans de ma carrière aux facteurs humains dans le cadre de l’analyse des incidents et accidents, le modèle de James Reason reste celui le plus à même de guider une analyse et de suggérer des stratégies de prévention et de mitigation.

J’ai également toujours plaidé pour que les facteurs humains restent un outils de réflexion parmi d’autres et non pas une fin en soi.

Ayant relu les commentaires des autres lecteurs, je suis d’accord que le modèle HFACS (développé, je crois, par l’US Navy) est une approche très complète, tout à fait dans l’esprit du concept TEM ( Threat and Error Management ) adopté par l’OACI et IATA.

La plupart des méthodes d’analyse modernes s’inspirent d’ailleurs du modèle de James Reason, du HFACS et du concept TEM.

La compréhension des graves accidents dans les grands systèmes complexes industriels (chimie, énergie …) ou de transport (aérien, ferroviaire …) ne peut se résumer à la recherche des causes par une méthode comme l’arbre des causes, qui est trop limitative et ponctuelle, ne prenant en compte que les circonstances immédiates de l’accident.

L’approche systémique considère tout l’environnement de travail des opérateurs et cherche à comprendre pourquoi les défenses techniques, humaines et organisationnelles mises en place n’ont pas permis d’éviter l’accident : l’analyse des défaillances d’un système complexe selon le modèle du « fromage suisse » (ou des plaques trouées) de J. Reason permet d’illustrer cette gestion systémique des risques : http://www.officiel-prevention.com/formation/formation-continue-a-la-securite/detail_dossier_CHSCT.php?rub=89&ssrub=139&dossid=519