L’erreur est humaine, persévérer [dans son erreur] est diabolique. Qui n’a jamais entendu cette citation attribuée par erreur à Sénèque (An 4 av. JC). En fait l’auteur serait Cicéron (An 106 av. JC). Mais encore une fois c’est une erreur de traduction, Cicéron se serait inspiré d’une pièce d’Euripide écrite en l’An400 av. JC. Bref, nous sommes en plein cœur du sujet : l’Erreur…

Depuis l’apparition d’une forme de vie unicellulaire sur notre planète il y a 3,5 milliards d’années, l’erreur est au cœur de l’évolution. Dès le départ, l’erreur a guidé l’évolution dans un mode binaire : erreur – solution, en clair s’adapter ou disparaître. La nature a développé un arsenal considérable de solution. Elle avait le temps et ne s’est jamais encombrée de considérations morales ou éthiques.

L’évolution humaine n’a pas échappé à cette dure règle. Cependant, nos ancêtres ont très vite compris que le résultat de leurs actes ou de leurs projets n’aboutissait pas forcément au résultat attendu. Lorsque l’on taille un silex pour en faire une pointe de flèche on apprend très vite que si on ne place pas ses doigts au bon endroit, ça peut avoir des conséquences douloureuses.

Pendant des millénaires, l’erreur a été considérée comme une fatalité. Les forces en jeux restaient modestes, les conséquences aussi. Et puis tout s’est considérablement accéléré en l’espace de 200 ans, depuis la révolution industrielle. Les vitesses, les forces et les énergies ont changé d’échelle de façon exponentielle.

Le 8 mai 1842, le train à double traction Versailles Meudon déraille à la suite d’une erreur de communication entre les deux machinistes. Le bilan est lourd, 55 morts dont l’explorateur Dumont d’Urville et sa famille et plus de 150 blessés. C’est la première catastrophe industrielle d’une telle ampleur et la première enquête. L’homme découvre que l’erreur n’est plus une fatalité mais liée à de nombreux paramètres annexes (concurrence entre deux exploitants, décision de doubler le nombre de wagons, mauvaise communication entre les deux machinistes un anglais et un français, etc.).

Les enquêtes, très sommaires au départ, se sont d’abord orientées vers les accidents industriels terrestres et maritimes. L’analyse des décombres, du témoignage des témoins et des rescapés rendait l’exercice, certes difficile mais possible. Le constat restait tout aussi sommaire : L’erreur, toujours elle, était toujours au cœur du problème. Sa gestion restait basique, écarter l’opérateur défaillant, étoffer les procédures, améliorer la formation. Les considérations financières et morales continuaient à polluer le débat. L’information restait confidentielle. L’objectif était de rassurer le système afin qu’il puisse continuer à fonctionner.

Et puis l’homme a commencé à explorer la troisième dimension. Reproduisant en quelques années seulement et en accéléré l’histoire de son évolution. Tout ceci avec un puissant catalyseur représenté par le second conflit mondial. L’analyse a posteriori de cette période est terrifiante. Plus d’un tiers des pertes d’avions de l’USAAF entre décembre 1941 et août 1945 soit 21583 sur 61164 survint au dessus du continent américain. En Angleterre, en 1944, 2835 avions de la 8 éme Air Force furent détruits sans aucun rapport avec les combats.

L’erreur, dans ce tout nouveau contexte, était de nouveau considérée comme une fatalité et le restera jusqu’à la fin des années 60. Les solutions envisagées alors se limitent à une sélection impitoyable et une formation implacable. Cependant le nombre d’accident reste élevé, les pertes au combat inacceptables. Entre 1955 et 1969, plus de la moitié des pertes humaines ne sont pas liées aux combats.

Le précurseur d’une nouvelle vision est Dan Pedersen, Capitaine de Frégate de l’US Navy qui créé la fameuse école TOP GUN en 1969 avec 9 autres officiers subalternes autonomes et en dehors de toute autorité politique ou militaire. Le premier conseil figurant sur le mur de la briefing room fut : « les voitures, les avions ou les missiles sont faits pour tomber en panne, prévoyez les problèmes et anticipez les ! ». La Navy Fighter Weapons School n’a connu que très peu d’accident dans son histoire.

Le 29 décembre 1972, le vol Eastern Air Lines 401 en approche à Miami remet les gaz à la suite d’une panne de train d’atterrissage. L’équipage se met en attente pour régler le problème. L’avion s’écrase quelques dizaines de minutes plus tard dans les Everglades. Cet accident emblématique sera le point de départ de l’intégration des facteurs Humains en aéronautique. Une simple ampoule grillée de quelques centimes a coûté la vie à 101 personnes et à la perte d’un avion de plusieurs centaines de millions de dollars. Pour la première fois dans l’histoire de l’aviation, une enquête mettra le doigt sur la gestion de l’erreur et le travail en équipage.

Moins de 5 ans plus tard en mars 1977, l’accident des 2 Boeing 747 à Tenerife rendra nécessaire et indispensable l’analyse et la compréhension du comportement humain.

Le précurseur est Rasmussen qui élabore dès 1979 son modèle simple SRK.

- – Le savoir faire (Skill)

- – Les règles (Rules)

- – Les compétences (Knowledge).

Rasmussen s’appui sur l’analyse des accidents aériens entre 1950 et 1979 vue du côté des pilotes pour lesquels les défaillances sont dues pour :

- – 50% au manque de savoir faire ;

- – 30% à une erreur de décision ;

- – 10% à une erreur de perception ;

- – 10% à une cause technique.

Mais aussi du côté des mécaniciens pour lesquels les défaillances sont dues pour :

- – 65% au manque de savoir faire ;

- – 35% au manquement aux règles ;

- – 3% au manque de compétences.

Son système ne résiste que quelques mois. En mars 1979, l’équipe de quart de la centrale nucléaire de Three mile Island perd le contrôle du réacteur qui fond en partie. Libérant de ce fait une quantité de matière radio active dans la nature. 72h avant l’accident, lors d’un test de sécurité, une négligence dans une procédure entraina la fermeture d’une vanne du circuit de refroidissement secondaire. Lors de l’accident sur le circuit de refroidissement primaire, le circuit secondaire ne put pas prendre le relais entraînant la surchauffe du réacteur.

Le modèle de Rasmussen a très vite atteint ses limites. Il ne prenait pas en compte l’interruption des tâches, la distraction, la fatigue, le sous entrainement, le manque de connaissance, etc.

Au début de l’année 1980, Reason s’inspire des travaux de Rasmussen et propose sa propre classification de l’erreur. Il classe l’erreur en 2 catégories : Involontaire (Raté, Lapsus, Faute) ou volontaire (Faute, violation). Il va même plus loin en établissant qu’une erreur sans conséquence reste une erreur mais qu’une erreur qui entraine une conséquence devient une faute. C’est la première fois qu’apparaissent les notions d’interruption de tâche, l’erreur de représentation et la violation exceptionnelle. Le système industriel se contente dans un premier temps de son analyse.

Le 26 avril 1986, à la suite d’un enchainement d’erreurs, le réacteur n°4 de la centrale de Tchernobyl explose.

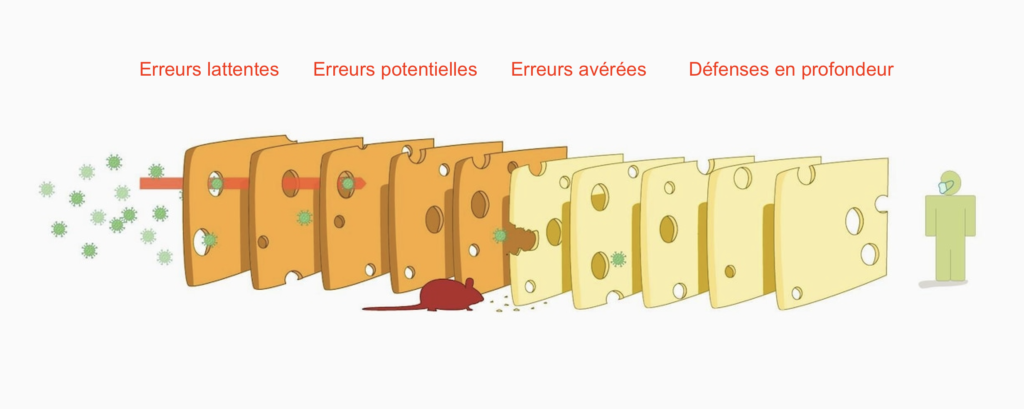

Le fonctionnement de l’être humain ne peut plus être considéré comme binaire. Reason poursuit ses travaux et propose au début de l’année 1990 son modèle emblématique du « Swiss Cheese ».

L’ensemble de l’industrie, de la formation au service qualité va s ‘emparer de son modèle, le modifier, l’adapter jusqu’à le rendre incompréhensible.

Le 15 janvier 2009, le vol US Airways 1549 est victime d’une collision aviaire après son décollage de La Guardia à New York. Le Commandant Chesley Sullenberger (Sully) réussit à poser son A320 dans l’Hudson sauvant l’intégralité des 155 passagers et de son équipage. Après de nombreux atermoiements, l’enquête retiendra entre autres le facteur chance, le savoir faire et la personnalité du pilote. (Nous y reviendrons dans une autre chronique).

Après avoir dressé la liste non exhaustive des situations pouvant générer une erreur, il est temps de s’intéresser aux solutions potentielles. Comme le préconisait Dan Pedersen. Connaissons les et anticipons ! Il n’existe aucune solution miracle. Aucune ne peut prendre en compte de façon absolue toutes les situations et la centaine de paramètres qui peut conduire à commettre une erreur. Aucune ne peut s’adapter à l’ensemble d’une population et à ses centaines de personnalités et de caractères différents. Nous aboutirions alors à une procédure inapplicable de par sa complexité.

L’industrie se rapproche du risque zéro mais elle ne fera que s’en approcher. La fuite en avant de la technologie est inéluctable. Elle s’accélère même de façon exponentielle. Mais l’humain, aussi doué soit il, restera un humain avec ses faiblesses et ses failles. Cela veut il dire que la fatalité a encore sa place dans notre industrie ? Il existe pourtant des pistes intéressantes. Un aéronef, un obstacle et un pilote ne sont pas dangereux. C’est l’addition des trois qui le devient !

L’industrie se rapproche du risque zéro mais elle ne fera que s’en approcher. La fuite en avant de la technologie est inéluctable. Elle s’accélère même de façon exponentielle. Mais l’humain, aussi doué soit il, restera un humain avec ses faiblesses et ses failles. Cela veut il dire que la fatalité a encore sa place dans notre industrie ? Il existe pourtant des pistes intéressantes. Un aéronef, un obstacle et un pilote ne sont pas dangereux. C’est l’addition des trois qui le devient !

Un aéronef ne décide pas de devenir incontrôlable ou d’être en panne. Il a été construit suivant un cahier des charges rigoureux. Des ingénieurs et des pilotes d’essais en ont étudié et fixé le domaine de vol. Ils ont établi une liste de procédures applicables dans des situations précises et laissent bien souvent au bon sens de l’opérateur le soin de trouver la solution adéquate pour LA situation exceptionnelle. Les exploitants ont affinés ces procédures pour les adapter à leur exploitation. Ce sont les fameuses S.O.P. (Procédures Opérationnelles Standards). Elles sont mises à jour régulièrement en fonction des aléas opérationnels. D’autres part, des contrôles réguliers permettent de vérifier que les opérateurs ne « dévient » pas de ces procédures ou que celles ci sont toujours adaptées.

Mais lorsque nous n’évoluons pas dans un cadre opérationnel ? L’erreur survient lorsque la vision de la situation élaborée par le pilote ne correspond plus à la réalité en raison de toutes ou partie des raisons identifiées plus haut. Un obstacle ne se place pas de lui même sur une trajectoire. Une piste ne raccourci pas ou ne décide pas de devenir glissante. Un interrupteur, une manette ou un sélecteur ne se placent pas tout seul dans la mauvaise position. Les phénomènes météorologiques existent depuis des millions d’années. Ils sont parfois destructeurs mais c’est bien au pilote de juger de leur menace et non pas l’inverse.

Alors reconnaissons que la rigueur, le respect des procédures mais surtout que la connaissance honnête et objective de ses capacités, de son domaine de compétence ou de ses lacunes sont les meilleurs remparts contre l’erreur. Il appartient à chacun d’entre nous de se montrer responsable, d’identifier nos limites, de les améliorer, de les entretenir et de les consolider par un entrainement efficace et rigoureux. Restons honnête intellectuellement, ne nous leurrons plus et adaptons nous sous peine de disparaître !

Bons vols,

Christophe BRUNELIERE